Meta的Llama系列模型代表了人工智能领域,特别是在大型语言模型(LLMs)方面的重大进展。Llama 3的推出体现了Meta专注于不仅参与而且引领人工智能竞赛的承诺,使其与像OpenAI的GPT-4这样的成熟模型展开直接竞争[1][2]。这些模型的开发基于开源原则,促进了人工智能社区内的协作和创新。预计这种方法将鼓励新的开发者生态系统,从而增强各个行业中人工智能应用的多样性和质量[3][4]。

Llama 3的进展还展示了在模型规模扩展和推理系统设计改进方面的重要突破,解决了在多种硬件环境中部署的实际挑战[3]。此外,Meta将Llama 3战略性地融入其平台,包括Facebook、Instagram、WhatsApp和Messenger,体现了其将先进的人工智能能力广泛提供给全球用户的强大承诺[2]。随着Meta AI在多个国家的推出,该公司旨在通过提供更智能、更快速的人工智能工具来增强用户体验,以便于日常任务[2]。

此外,人工智能行业内的竞争环境正被诸如Anthropic的Claude 3和微软的事实锚定技术等最新发展所重塑,这些技术旨在提高人工智能输出的可靠性和准确性[1][5]。这种动态的创新格局不仅提升了人工智能技术的标准,还影响了行业领导者(包括Meta)在推动人工智能能力和应用边界方面的战略举措[1]。

Llama 是一系列由 Meta 开发的开放大型语言模型(LLMs)和大型多模态模型(LMMs)。这一举措代表了 Meta 针对 OpenAI 和 Google 这两个主导竞争格局的战略响应,突显了其在研究和商业应用方面对开放性和可及性的承诺。[6] Llama 系列旨在为封闭源代码的 AI 提供一个可靠的替代方案,推动科技社区内的创新和实验。[6]

Llama模型,尤其是Llama 3.2的一个突出特点是它们针对设备端部署的优化。这种方法解决了与云计算相关的关键挑战,如延迟、安全风险和高运营成本。[7] Llama模型使应用能够在智能手机和边缘设备上有效运行,使得即使在互联网连接有限的地区,先进的AI功能也变得可用。这种AI的民主化有望通过实现实时AI应用而不依赖云基础设施,改变医疗、教育和物流等行业。[7]

拉玛系列经历了显著的迭代改进,特别是2024年推出的拉玛3模型。每次迭代都建立在前一次的基础上,引入新特性并满足AI用户的多样化需求。例如,拉玛3推出了基于变换器架构的变体,参数规模为80亿和700亿,同时增强了文本生成能力,支持在更长上下文中的连贯性。[8]

Llama 3.2 特别擅长多语言文本处理,并提供高达 128K 代币的扩展上下文长度,使用户能够开发复杂的自然语言处理应用程序。此外,这些模型包括工具调用功能,使用户能够直接在设备上管理日历邀请等任务,从而增强用户体验和应用程序的多功能性。[7]

Llama 模型的整合已经扩展到增强现实(AR)等领域,展示了它们的适应性和响应能力。例如,Niantic 的 AR 游戏 Peridot 利用 Llama 创建与虚拟宠物的动态互动,丰富了游戏体验并促进了玩家与虚拟伙伴之间的情感联系。[9]

Meta的开源策略与Llama模型标志着一种更广泛的协作AI开发趋势。通过邀请全球开发者为这些模型贡献和构建内容,Meta旨在加速AI技术的发展,促进对该领域未来的共同愿景。[10][11] 这一转变不仅增强了Llama的功能,还将其作为AI工具包中的基础工具,从而营造出一个适合于生成性AI应用创新和探索的环境。[11]

Meta 强调了开放源代码 AI 模型广泛采用在美国经济和安全利益中所扮演的关键角色。随着全球对 AI 主导权的竞争加剧,像英国、印度和中国这样的国家正在取得显著进展,美国则寻求保持其技术优势。Meta 的举措,特别是 Llama 模型,旨在通过促进创新并确保 AI 发展与民主价值观保持一致,从而支持美国及其盟友的战略利益。[12][4]

Llama模型家族,特别是最新版本Llama 3.1,拥有多达4050亿个参数,并且致力于开源协作。这样的方式使组织能够根据具体需求调整AI技术,无论是为弱势地区的教育目的,还是通过多语言支持提升医疗服务。通过民主化对先进AI能力的访问,Meta旨在赋能多样化的开发者和组织,促进AI在各个行业的可扩展采用[12][7][13]。

Meta在巴黎的人工智能研究中心,称为基础人工智能研究中心,在Llama的发展中发挥了关键作用。该中心致力于创建基础模型和增强算法过程,这对于确保开源人工智能系统的稳健性至关重要。Meta对这一研究倡议的承诺强调了其对高质量、开放访问的人工智能解决方案的专注[4][11]。

Meta设想一个未来,开源AI促进不同实体之间的合作,确保AI工具反映全球社区的多元价值观和语言。这一愿景类似于自由和民主新闻的原则,知识库由多样化的输入塑造。Meta的理念强调,AI的未来不应被少数公司垄断,而应通过广泛的全球合作来发展[4][13]。

开源人工智能的实际应用延伸至各个领域。例如,Llama 3.2的功能可以实现实时预测分析,使企业能够高效地预测市场趋势和消费者行为。此外,本地部署AI模型的能力解决了与云计算相关的挑战,如延迟和安全风险。这种可获取性促进了在连接有限地区整合AI技术的可能性,进一步推进了民主化尖端技术的目标[7][14][11].

Llama系列,特别是在Llama 3.2中看到的进展,已经成为各行业多种应用的多功能工具。其开源框架使开发者能够将Llama模型集成到不同的平台中,增强在客服、医疗保健和增强现实等领域的功能,同时保持对效率和定制化的关注[7][11]。

在医疗保健领域,Llama 3.2 通过其精细调整的模型展示了显著的实用性,这些模型有助于分析患者记录和诊断医疗状况。其多模态能力使得模型能够处理医疗图像、文本数据和实验室报告的组合,从而帮助医生根据全面的患者历史建议个性化的治疗方案[13]。这一应用不仅简化了医疗环境中的工作流程,还促进了患者结果的改善。

法律事务所和企业法律部门越来越多地利用 Llama 3.2 来进行诸如自动合同分析和法律研究等任务。针对法律应用的定制模型经过微调,帮助最小化审查合同所需的时间,同时确保遵守适用法规。通过减少手动流程的负担,Llama 3.2 使法律专业人士能够专注于更具战略性的任务[13]。

Llama 3.2 最普遍的应用之一是在增强客户服务系统方面。该模型生成上下文感知、准确响应的能力显著减少了客户支持场景中对人工干预的需求。例如,Llama 3.2 支持创建能够理解图像的多模态聊天机器人,使客户可以上传产品的图片以获得故障排除帮助或更换建议[13]。这一功能提升了用户体验和运营效率。

Llama已成为增强现实(AR)领域的一项关键技术,特别是在增强用户互动方面。通过将Llama集成到AR应用中,开发者可以创建实时适应用户行为的动态环境。例如,Niantic的AR游戏Peridot利用Llama来驱动虚拟宠物的行为,从而丰富游戏体验,并促使玩家与他们的伙伴之间建立情感联系[9]。

Meta对打造可定制架构的承诺通过Llama 3.2回应了对超专业化应用日益增长的需求。企业可以根据自身的特定需求定制AI解决方案,从而部署智能系统,优化操作,而无需承担通常与云AI相关的高成本[13]。这种灵活性使Llama 3.2成为希望增强工作流程和推动创新的企业的关键工具。

公众对 Llama 3 的反应既充满热情又带有怀疑,反映了关于开源 AI 技术影响的更广泛讨论。一方面,Llama 3 的开源特性因其有潜力 democratize AI 能力和促进各个行业的创新而受到赞誉[1]。技术社区里的爱好者庆祝其可达性和定制化的前景,同时强调其架构改进提升了竞争性能[15]。

然而,这些积极的情绪也受到对 Meta 许可条款和使用如此强大工具的伦理影响的担忧所制约。批评者强调需要在训练数据和潜在的技术滥用方面实现透明性,指出与隐私、安全和知识产权相关的风险[1][15]。社区倡导的开源理念与商业利益驱动的动机之间的二元对立,形成了复杂的监管环境,提出了在 AI 部署中如何平衡创新与伦理标准的问题[1]。

除了伦理考虑,部分开发者对Llama模型的可用性表达了不满。针对有效使用这些模型的复杂性,出现了投诉,这促使Meta推出了旨在简化开发过程的“Llama Stack”[15]。这一举措反映了对开发者所面临挑战的认可,并强调了用户体验在AI技术采用中的重要性。

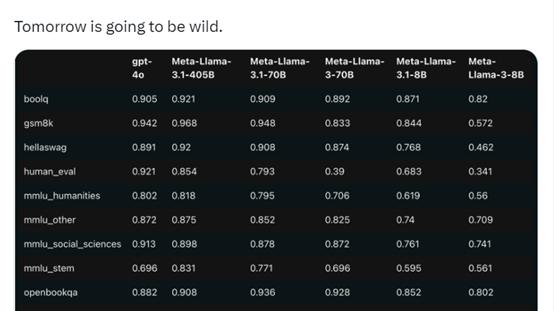

尽管对Llama 3的能力充满期待,但批评者指出缺乏全面的基准测试,这使得其相对于竞争对手如GPT-4和PaLM 2的性能优势存在不确定性[1]。缺乏明确的评估指标引发了关于Llama 3相对有效性的问题,特别是在其声称的优势方面。

正在进行的技术社区讨论,特别是在诸如Reddit和Hacker News等平台上,突显了社区参与在塑造关于Llama 3叙事中的重要性。随着公众舆论影响公司战略,这些对话揭示了在技术采用中必须考虑的社会价值观和优先事项[1]。此外,开发过程中的透明度措施和利益相关者参与被视为在早期识别潜在伦理陷阱的重要因素,从而丰富开发过程并增强问责性[16]。

LLaMA模型的未来轨迹,特别是随着LLaMA 3.1和LLaMA 3.2的推出,正准备迎来重大进展。这些更新旨在增强模型在专业任务中的能力,受到计算能力和机器学习算法持续改进的驱动。这一演变将促进各行业利用人工智能解决复杂问题的能力,例如,通过优化供应链和提供个性化客户体验来实现精细推荐[16][8]。

LLaMA 3.1 显著引入了高达 128K 词汇的上下文长度,使其能够分析和生成更大的文本序列。这一能力显著提升了其在包括代码辅助和多语言对话机器人等各种应用中的表现[17][18]。此外,自然语言处理 (NLP) 能力和上下文理解的进步预示着用户体验将得到提升,使 LLaMA 3.1 适合于高要求的任务[17]。

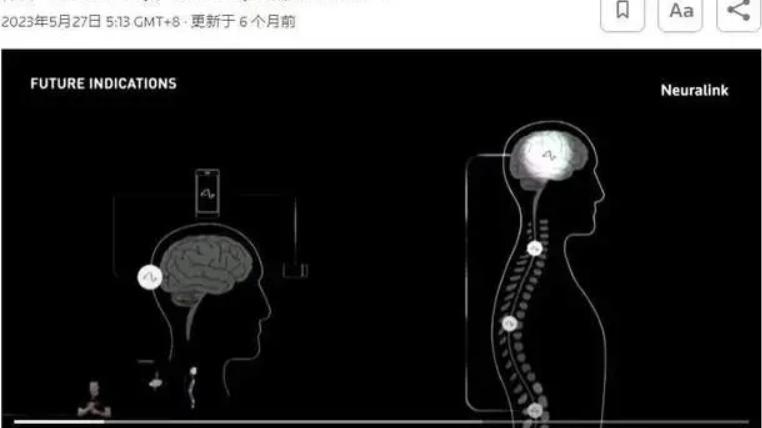

即将到来的LLaMA模型发展的一个关键方面是预期将朝着多模态转变,使模型能够处理文本和其他形式的数据,如图像和音频。这一能力可能使LLaMA在像GPT-4这样的竞争对手中脱颖而出,特别是在需要全面数据分析的应用中[19]。此外,Meta对开源开发的承诺将使开发者能够修改和调整模型以满足特定需求,从而促进全球人工智能社区内的创新[20][17]。

随着人工智能技术的发展,监管和伦理框架也将随之演变。像微软的事实锚定(Fact-Anchoring)这样的信任建立技术预计会变得更加普遍,以解决与错误信息相关的担忧,并确保更安全的人工智能使用[1]。随着开源生态系统的扩展,监管框架可能会适应变化,以维持伦理标准,并促进整个行业的负责任的人工智能实践[1][20]。

LLaMA及其后继者的旅程反映了Meta在开源AI开发领域的战略愿景,旨在引领创新,同时兼顾伦理考虑。预计的进展不仅承诺提高模型的性能和多样性,还将解决AI融入社会的更广泛影响,包括经济影响和潜在的误用[1][20]。随着这些模型的不断发展,它们在塑造人工智能未来中的作用仍然至关重要,培养了一个充满机遇和挑战的环境。

Meta对先进人工智能技术的追求体现在其Llama 3模型的发展上,这被视为一项战略努力,旨在超越OpenAI的GPT-4和Anthropic的Claude等竞争对手设定的现有基准。内部通讯透露,Meta的高管和研究人员展现了强烈的竞争精神,明确聚焦于将Llama 3确立为AI领域的领导者[21][1]。Meta的生成AI副总裁Ahmad Al-Dahle强调,达到超越GPT-4的能力是必要的,并指出公司准备利用前所未有的64,000个GPU来实现这一目标[21]。

Meta的内部讨论关于其人工智能倡议凸显出一种明显的紧迫感和雄心。领导层将Anthropic的Claude和OpenAI的GPT-4视为行业中的关键基准,围绕这些模型塑造Meta的竞争策略[21]。相比之下,该公司对开源领域的竞争对手,例如法国初创公司Mistral,表现出轻视的态度。Al-Dahle将Mistral的努力形容为无关紧要,宣称Meta有信心超越他们的表现[21]。

根据其雄心勃勃的人工智能战略,Meta 宣布大幅增加投资,计划在 2024 年额外拨款 100 亿美元用于人工智能基础设施。尽管这一决定最初遭到投资者的质疑,导致股票价格显著下跌,但最终随着投资者认识到这些昂贵目标的潜在长期收益,股价反弹。截至 2023 年 12 月,Meta 的股票同比上涨近 70%,显示出对其人工智能方向的信心日益增强[5]。

Meta 的战略方法不仅旨在超越其直接竞争对手,还旨在重塑关于人工智能发展的整体对话。通过 Llama 3,Meta 公司将在挑战现有规范和建立人工智能性能及安全的新标准方面处于有利位置。监管压力和市场竞争可能会影响人工智能技术的发展,强调需要标准化基准,以确保整个行业的一致安全性和有效性[1]。

Llama Unleashed: Exploring Meta’s Vision for an Open AI Future 是对Meta的Llama系列大型语言模型(LLM)的全面探讨,尤其是Llama 3,该模型将公司定位为在快速发展的人工智能(AI)领域中的强大参与者。通过强调开源原则,Meta旨在促进创新与合作,与OpenAI和Google等竞争对手的闭源方法形成对比。Llama 3的发布不仅增强了AI技术的可扩展性和可访问性,还在Meta的平台上集成了先进的功能,使复杂的AI工具能够为全球用户提供[1][2][3]。

Llama模型的意义在于其有潜力让AI民主化,使开发者和组织能够在包括医疗、教育和客户服务等各个行业定制和部署这些模型。Llama 3引入了许多功能,例如增强的上下文长度和多模态能力,使得实时应用得以在没有云计算限制的情况下运行。这种向本地部署的转变不仅提高了性能,还解决了与延迟和安全性相关的问题,尤其是在服务不足的地区[4][7][13]。

尽管受到乐观的评价,Llama系列并非没有争议。关于强大的开源AI工具的伦理影响,特别是透明性、潜在误用以及创新与监管标准之间的平衡,出现了一些担忧。批评者还指出了可用性的复杂性以及缺乏全面的基准来比较Llama 3与其竞争对手,提出了有关AI开发中性能和责任的重要问题[1][15][20]。

随着竞争环境的不断变化,Meta的开源方法旨在通过促进一个反映多元全球价值观的合作环境来重新定义AI开发。Llama及其后续产品的未来不仅将影响技术进步,还将塑造围绕AI的伦理话语,强调负责任的部署和社区参与的重要性[12][13][20]。

寻求专业报道请联系微信:LiteraryIntelligence

原创图片授权请联系微信:EmbodiedIntelligence

文章转载授权请联系微信:HumanoidIntelligence

文字内容修正请联系微信:SpacialIntelligence

Please provide the English text you would like to have translated into Chinese.